前几天看到兄弟公众号发了一篇文章,同样的标题,有一些不同看法, 如骨梗喉,不吐不快。特地码了一篇文章,抛砖引玉,聊作讨论。大家有什么不同看法,像下面的砖块,请随便招呼。三个五个,我要是躲,不算南人。

GPS导航在若干年前仅仅是一个边缘的应用,去陌生的地方偶尔开一开。可是自从出现了实时路况,实时修改路径规划,规避堵塞,GPS导航就变成了驾车一族的刚需, 地图导航也从普通应用变成了O2O的入口。我几乎每天开导航上下班,即使坐地铁也要开导航,避免坐过站。这样一来,过去未必重视的GPS灵敏度就变得非常重要(敲黑板,此处学习得好的可以加工资)。

GPS 信号是从距地面大约 20000km 的LEO(Low Earth Orbit,低轨道卫星。)卫星上发送到地面上来的,其L1 频段(fL1=1575.42MHz)自由空间衰减为:

按照GPS 系统设计指标,L1 频段的C/A 码信号的发射EIRP(Effective Isotropic Radiated Power,有效通量密度)为P=478.63W(26.8dBw),假定大气层衰减为A=2.0dB,则GPS 系统L1 频段C/A 码信号到达地面的强度为:

由于不同纬度卫星仰角的不同、以及受树木、建筑物等的遮挡,高纬度L1 频段C/A 信号到达地面的强度可能会低于-160dBw,雨雪天气可能会低于-163dBw。

有童鞋可能质疑,为什么采用自由空间传播模型?的确,考虑地面反射,通常都会有一定的增益。 这里解释一下,由于多径效应严重降低定位精度,GPS采用右旋圆极化,有抑制反射波的特性,反射本身信号又有衰减,本处计算忽略了地面反射波的合成作用,是符合基本状况的。

换算成我们常用的dBm, GPS信号的理论下限就是-127.6dBm,对比GSM手机侧的截止接收信号电平-102dBm,小了25.7dB,大概弱了370倍。这就是为什么GPS信号难以处理的直接和主要原因,因此许多GPS专业接收器都采用外置天线加LNA的方式提高接收灵敏度, 业内水平基本都可以达到-160dBm的接收灵敏度, 满足在大楼边或者密林中,大雪中的GPS信号接收。

手机中限于体积,只能采用内置天线,而且布置位置严重受限,对灵敏度处理格外困难。

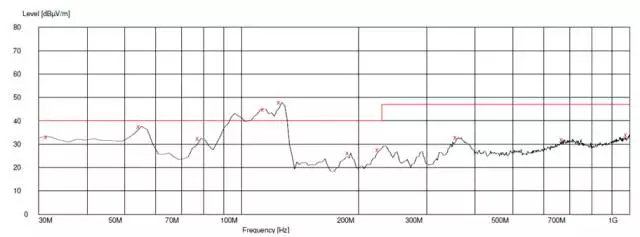

在充电的时候,突然发生GPS接收灵敏度的大幅度下降,通常有3个原因:

1. 充电输入电流的导致的干扰

2. LX点振铃电压导致的干扰

3. 充电热效应导致的PLL频率偏移

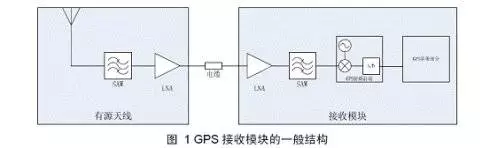

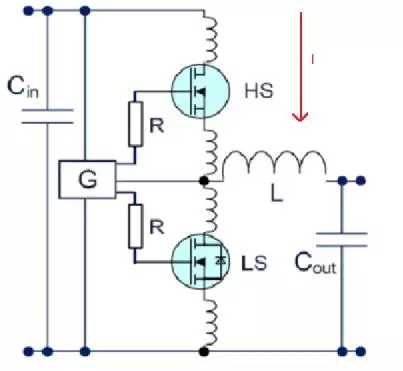

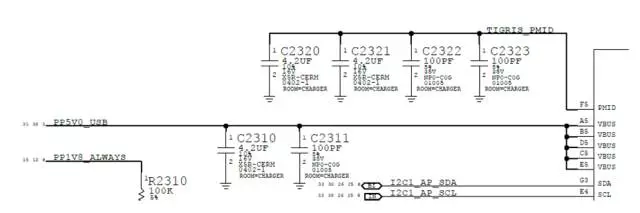

拿iPhone6s的充电结构图来说吧,有下面三个潜在的问题点。

图1.

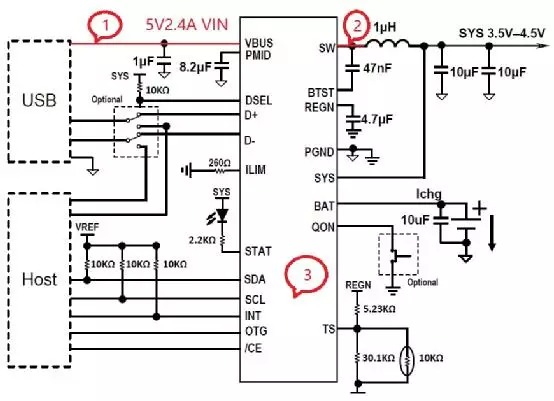

这是一个典型的降压DC-DC转换,我们最容易想到的,就是2处出问题。 在2的位置,充电的时候将会出现如下图的振铃(仿真波形)

图2.

这个振铃被认为是DC-DC的固有结构导致的,只能减弱,不可能消除。

图3.

原理上可以这样理解:在上图中,上管导通,下管关闭,电流I流过高侧的寄生电感和导通的高侧的MOS管,和低侧的MOS管Cds以及LX这一点对地的分布电容产生谐振。

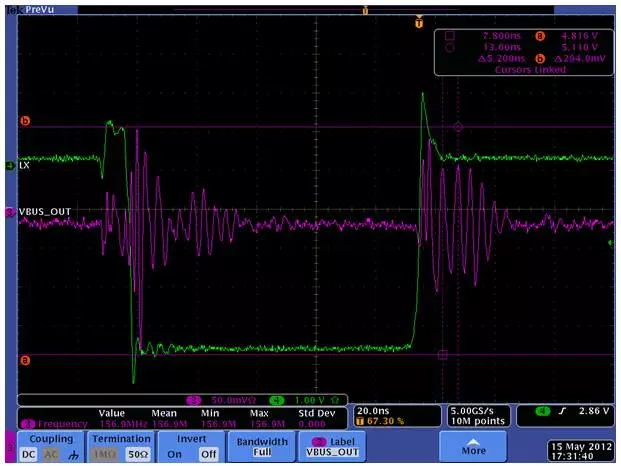

下图是一个真实电路的测量:

图4.

这是5V 500mA的DC-DC波形图,绿色线就是LX点的电压,可以看出,尖峰电压可以达到输入电压的120%~130%。这个尖峰蕴含了丰富的高次谐波,是很多干扰的源头。

总的来说,2处的干扰是dv/dt形成的干扰,是电场干扰,可以通过紧凑的Layout布局来限制,如果布局已经定下来,无法大改,可以简单地在LX对地并联一个10~30pF的电容,主要是降低寄生谐振的Q值,并没有让谐振能量消失,可以增加1k电阻和该电容串联,可以进一步吸收谐振能量,但对DC-DC转换效率有所影响。

如果你在2增加了snubber吸收电路,可是插上充电,问题还是没有解决, 怎么办?

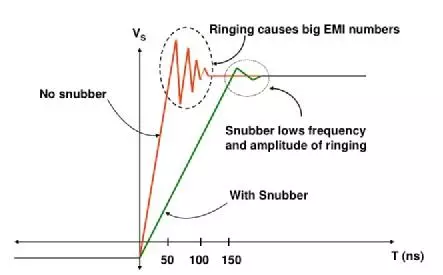

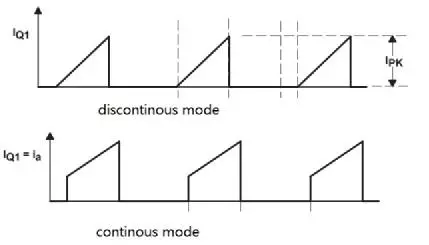

原来开关模式的充电, 除了LX这一点是干扰源之外, 还有一个干扰源,就是交流适配器输出线或USB充电线上的电流。我们平常说5V2.1A电流,说的是平均电流。理论上电流波形是这样的:

图5.

在手机领域,为了避免电磁干扰的不确定性,通常采用固定频率的开关转换,电流小的时候是上面的波形,电流大的时候就是下面的波形。即使我天性鲁钝,不太懂拉普拉斯分析,傅里叶分析,也能看得出,这两种电路中含有非常丰富的谐波成分,换成人话,就是它们是干扰大热门。

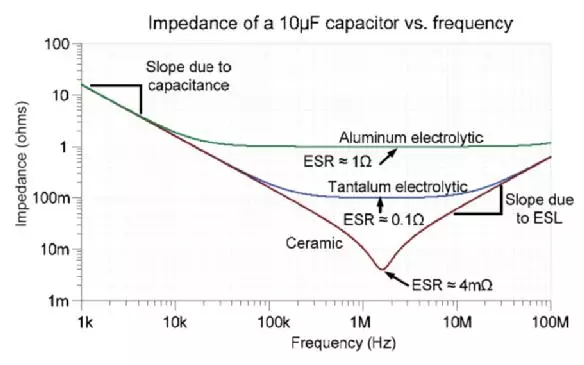

如同在图1中所示,通常会有一个退耦电容1~10uF在输入端,滤除高频成分。对非射频敏感应用通常是足够的。 但是如果你看看一般MLCC的电容特性,遇到GPS这种极端敏感应用,心里就不会那么放心了:

上图是一个10uF各种电容的频率特性,100MHz以上已经接近一个电感了,没有什么滤除效果了。在图1的1uF旁边并联一个陶瓷22pF电容,或者同时在PMID也就是内部降压DC-DC充电的输入口并联一个22pF电容可以极大改善射频干扰。

不服气?看看苹果是怎么干的?有图为证!

苹果用了2个4.2uF加2个100pF并联形成PMID的退耦,用了1个4.2uF加100pF在输入形成2层过滤。之所以分开有一部分考虑是规避USB插入瞬间的浪涌电荷不超标。

还有一个办法来锁定问题根源是不是由于电流辐射,就是用不同荷电状况(SoC)的电池来充电,这样充电电流可能从2A到200mA不等,如果我们可以得到不同的灵敏度下降状况,即可锁定。

曾经有一个客户的辐射超标,他们就很鸡贼地用快充满电的电池过了关。我们不推荐这种解决问题的方法,但欣赏这种思考问题的方法。

有了前面两招,绝大多数场合GPS的灵敏度都不错了 你的问题也就基本回答了。 但是的但是,今年情况特殊,因为天气太热了,因为现在的智能手机一旦启动内部温升往往很大, 但温度上升和灵敏度有什么关系呢?

我的第三个问题点就标在了充电芯片本身上。其实,并不是说充电管理芯片本身导致GPS灵敏度下降,而是说在充电的时候往往额外散发出1~2W的热量,应用处理器侦测出处于外部电源供电,也采取较高性能的运行方案,系统会散发更大的热量。因此在充电的时候运行GPS导航软件, 机身往往会有20~30摄氏度的温升。

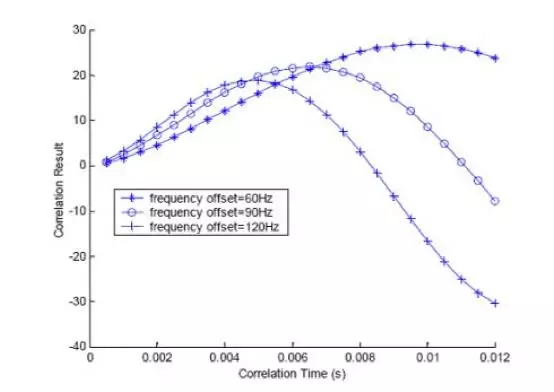

GPS 信号是一个扩频系统,GPS卫星发出一种伪随机码C/A码,用于粗测距和捕获GPS卫星。对于C/A 码而言,其扩频码为码长1023 的Gold 码,码速率为1.023Mcps,即每1ms 为一个C/A 码周期。扩频增益Eb/N0可以通过提高本地码和接收信号之间的积分时间来提高。

相干累积结果和相干累积时长非常相关,积分方式分为相干累积和非相干累积。相干累积是指直接用本地码和接收信号按位相乘后再累加,而非相干累积则是对相干累积的结果平方再进行直接相加。

以相干累积为例(非相干累积计算复杂,不讨论),相干累积时间越长,对输入信噪比的要求越低,其灵敏度也就越高,但累积时长过长,由于频偏Δf 的影响,上式中第一项值也会越小,又会降低其灵敏度。

因此,一般高灵敏度的GPS 接收机都需要采用频率稳定度较高的TCXO 作为本振,以降低本地频率和载波频率之间的偏差。一般而言,高灵敏度的基带算法对本振的稳定度要求在8ppm 左右,该稳定度包括校正偏差、老化以及温度补偿稳定度,对于频率校正稳定度为2ppm、老化稳定度为5ppm 的TCXO 而言,一般要求其温度补偿稳定度在0.5ppm 以内。

以上图为例,频偏60Hz的就可以采取长得多的相干时间来达到更高的灵敏度。

手机3G/4G射频对晶振有苛刻的要求,然而,GPS有更高的要求。我不止一次遇到某品牌的手机在阴雨天气找不到卫星,然而放在出风口吹几分钟马上找到的尴尬,也不止一次在连续使用GPS几小时后在无遮挡的高速上短时间失去卫星连接,几分钟后自动恢复。这些小的瑕疵都指向一个问题,就是晶振的温度特性有待提高。

作为GPS系统的调试人员,遇到充电的时候灵敏度下降,不妨把眼光投射到射频系统之外。假如能确定是温升问题导致灵敏度下降,要解决这个问题倒是很简单,一是换用更低漂移的晶振,二是把晶振位置远离热源,三是在充电的时候限制最大温升。

最后我们总结一下GPS充电时候灵敏度下降的三个最有可能问题点:

1.振铃电压干扰

2.高次电流干扰

3.热导致的频偏

也有可能是三个点同时影响了灵敏度,我们必须同时考虑三点。

转载请注明:徐自远的乱七八糟小站 » 手机充电时,GPS灵敏度下降4dB怎么办?