动画图解RNN, LSTM 和 GRU,没有比这个更直观的了

原创 AI公园 2019-07-22 21:15:44

作者:Raimi Bin Karim编译:ronghuaiyang

导读

RNN, LSTM 和 GRU是3个非常常用的循环神经网络,这三个东西里面的内部结构又是什么样的呢,很多人可能并不清楚,不过除了RNN外,其他两个也确实比较复杂,记不住没关系,看总能看明白吧,看不明白也没关系,动画演示给你看!

循环神经网络是一类人工神经网络,常与序列数据一起使用。最常见的3种循环神经网络是普通循环神经网络(RNN)、长短时记忆(LSTM)和门控循环单元(GRU)。

有很多关于循环神经网络的图解。我个人最喜欢的是Michael Nguyen在这里发表的那篇文章,因为他让我们对这些模型有了直观的认识,更重要的是,他的漂亮的插图让我们更容易理解。但我这篇文章背后的动机是更好地可视化这些单元中发生的事情,以及节点如何被共享,以及它们如何转换以提供输出节点。迈克尔的动画也给了我灵感。

本文研究了普通的RNN、LSTM和GRU单元。这是一个简短的文章,是给那些对这几个东西有所了解的人准备的。(我建议在阅读本文之前先阅读Michael的文章。)需要注意的是,以下动画是连续的,但不反映向量计算时的时间顺序。

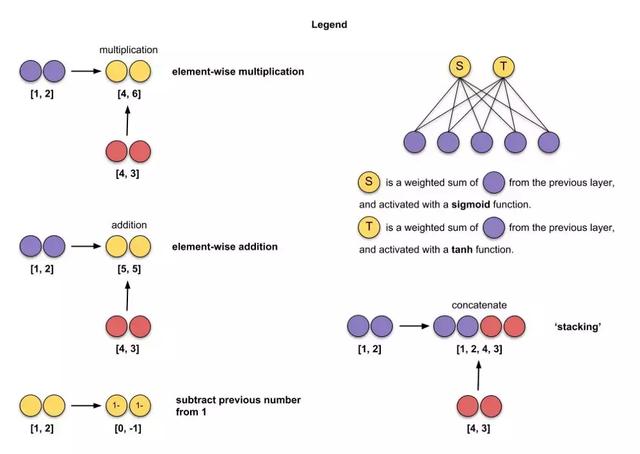

这是我在插图中使用的图例。

在我的动画中,我使用的输入尺寸为3(绿色)和输出尺寸为2的隐含单元(红色),batch size为1。

我们开始!

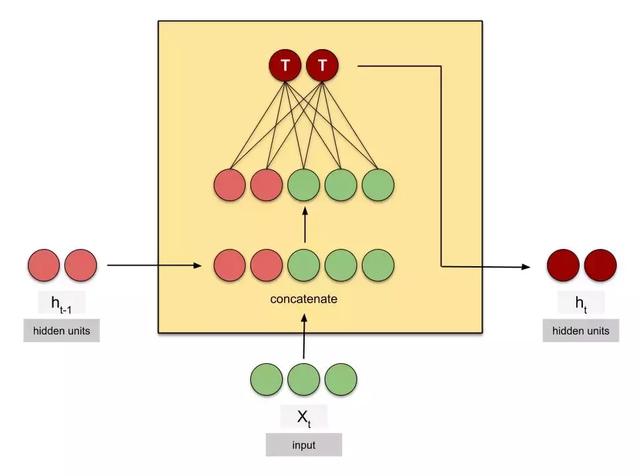

RNN

- t — 时间步

- X — 输入

- h — 隐含状态

- length of X — 输入的尺寸/维度

- length of h — 隐含单元的数量,注意,不同的库名字不一样,但是含义是一样的:

- – Keras — state_size,units

- – PyTorch — hidden_size

- – TensorFlow — num_units

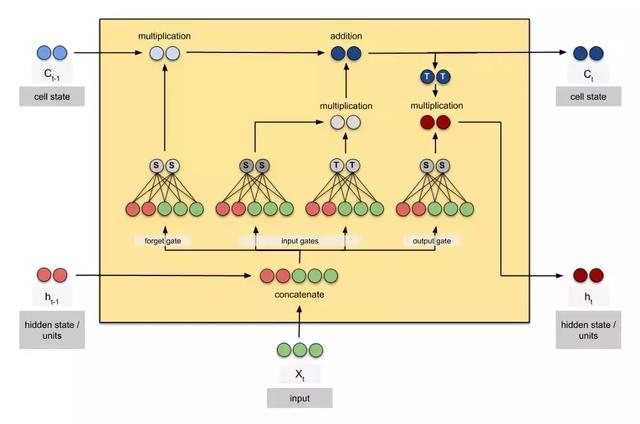

LSTM

- C — cell 状态

注意,cell状态的维度和隐含状态的维度是相同的

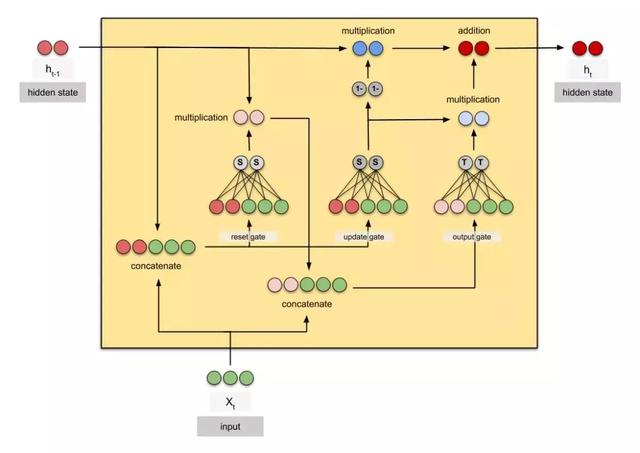

GRU

希望这些动画可以帮助到你,这里是这些cells的静态图:

原文链接:

https://towardsdatascience.com/animated-rnn-lstm-and-gru-ef124d06cf45

动画图解RNN, LSTM 和 GRU,没有比这个更直观的了http://t.zijieimg.com/fLdFKX/