「速读论文」改变一个像素,就可以攻破任何AI?(附源码、pdf)

机器学习干货君|原创

》》》源码&论文pdf位于文末》》》

Source: Su & Vargas et al. 2018

改变一个像素,AI 就会把乌龟当作猎枪?

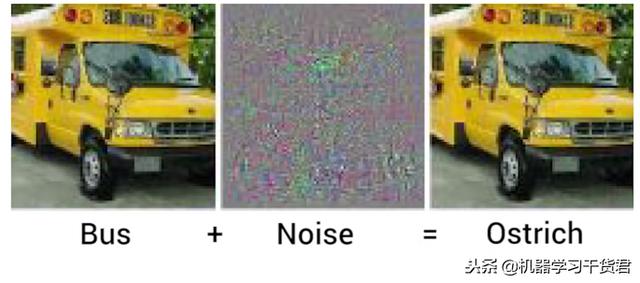

相信很多人对图像识别攻击已经见怪不怪了:

可见,通常的实现方法是为一张图象附加大量的噪声,以达到欺骗神经网络的目的

如图,被攻击的AI会把危险的武器当作日常可见的交通工具。这种攻击的危险性可想而知。

可毕竟加了许多噪声,伪造图像还有被识破的可能。

如果只删除一个像素,这种改动恐怕是难以被侦测的。

但是,只删除一个像素就能让绝大多数完备的图像识别模型失灵,这不可能吧?

仅改动了一个像素的猫

或许有读者会质疑:“太荒谬了。单像素攻击肯定只能针对那些基础简单的模型。

凡是拥有一定鲁棒性的模型不会因为单个像素改变判断结果!”

那不如让我们来看一些例子:

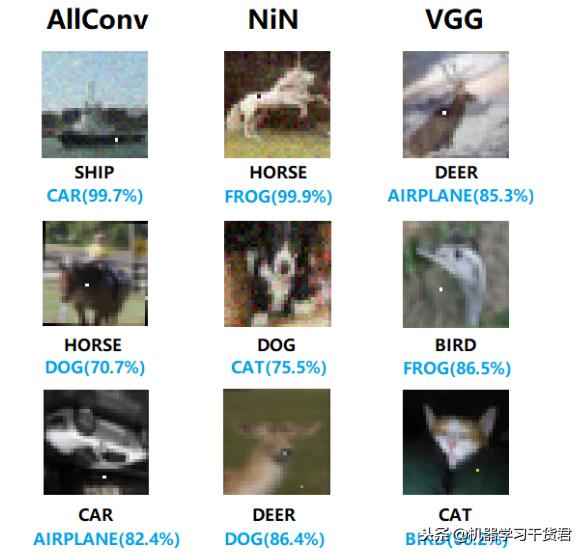

下图是对 VGG 模型的攻击结果

VGG 模型是 2014 年 ILSVRC竞赛 的第二名,仅次于当年的 GoogleNet。

所以 VGG 是公认的拥有一定稳定性和实用性的模型。

但是如图可见:

仅删除一个像素,VGG 便把鹿和船认成了飞机,把鸟当作了蛙!

而且这并不是个例:

如图可见,许多著名的图像识别模型都沦为了单像素攻击的牺牲品!

文末附加了实现单像素攻击的源码,敬请自取

这到底是怎么做到的?现代图像识别模型还安全吗?

且让笔者为大家介绍,Su & Vargas等人 2018 年的成果:

单像素攻击是如何做到的

原理

其实这一切还是基于生成式对抗网络(GAN)的思想。

我们知道,GAN 包含了

- 判别器(Discriminator)

- 生成器(Generator)

他们两个会在不断进行的对抗训练中变得越来越强大。

只不过这一次,

- 判别器是我们攻击的目标

- 生成器需要学会如何改变图像像素来欺骗判别器

由于判别器不会增强,

(我们也不希望它增强)

Su & Vargas等人把训练生成器的过程当作一个寻找全局最优的过程:

神经网络模型的三维结构展示

举个例子:

对于这张猫的照片,原本判别器会给它一个很高的置信度,比如 90%

而生成器的目的就是寻找一个修改像素的位置,使得这个置信度尽可能的降低。

最终,其他类别的置信度就会超过它:

猫被当作了狗(78.2%置信度)

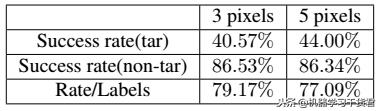

最后,就让我们来看看他们的实验结果:

可见,对于大多数图像识别模型,要想实现一个有目的性的攻击

比如明确地要把日常用品识别为武器

改变三个像素就能拥有 40.57% 的成功率

而如果只是想让模型失灵

改变极少量(5 pix)的像素即可达到 86.34% 的成功率

可以说是令人细思极恐的结论

↓↓↓附件领取请看这里↓↓↓

请先点击关注;然后私信发送“onepix”

即可轻松领取本篇论文pdf文件及相关程序源码

机器学习干货君致力于原创易于理解的技术原理与细节文章

I Study Hard,

So YOU Don’t Have To !

欢迎大家关注: )

「速读论文」改变一个像素,就可以攻破任何AI?(附源码、pdf)http://t.jinritoutiao.js.cn/RcnJJy/