这里介绍2个python中文处理的包,分别是jieba和snownlp,这2个包处理起来中文都挺简单的,下面我简单介绍一下这2个包的安装和使用,实验环境win10+python3.6+pycharm5.0,主要内容如下:

- jieba分词:这个中文处理包比较常用,大部分都应该听说过,可以实现分词、标注词性、提取关键词等大部分功能,使用起来挺简单的,下面我简单介绍一下这个包:

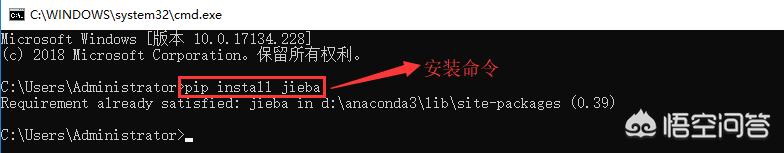

1.下载安装jieba,这里直接在cmd窗口输入命令“pip install jieba”就行,如下:

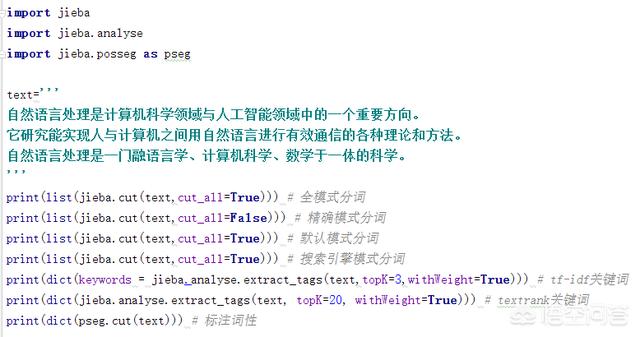

2.测试代码如下,这里主要演示了一下分词、提取关键词、标注词性等:

程序运行截图如下:

- snownlp分词:snownlp是python的一个中文处理包,受TextBlob算法启发而写,所有算法都是作者本人自己实现,而且还带了一些训练好的字典,下面我简单介绍一下这个包:

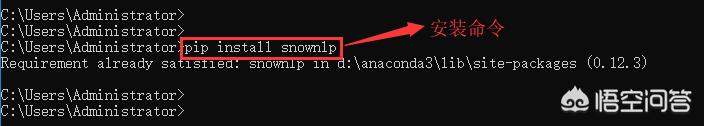

1.下载安装snownlp,这里直接在cmd窗口输入命令“pip install snownlp”就行,如下:

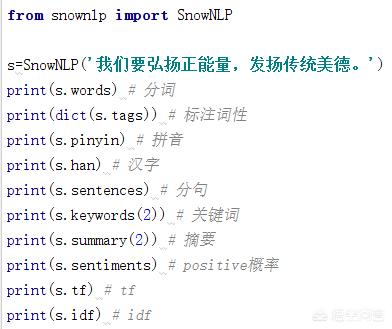

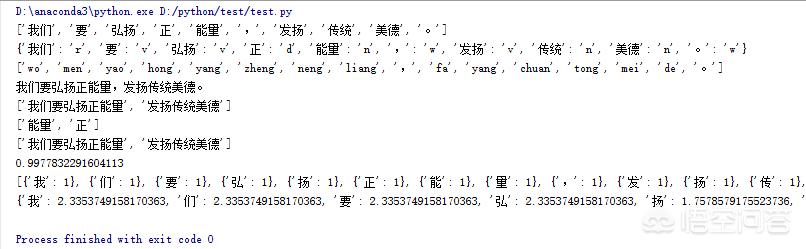

2.测试代码如下,这里简单的测试一下分词、标注词性、关键词等:

程序运行截图如下:

至此,就完成了jieba和snownlp的这2个中文处理报的简单安装和使用。总的来说,整个过程挺简单的,网上也有相关教程和资料可供参考,其实还有其他中文处理的包,像thulac,corenlp,pynlpir等,这里就不详细介绍了,感兴趣的可以搜一下,希望以上分享的内容能对你有所帮助吧。

有哪些好的python用的中文自然语言包推荐?http://t.jinritoutiao.js.cn/dJrAp2/

转载请注明:徐自远的乱七八糟小站 » 有哪些好的python用的中文自然语言包推荐?