Science重磅!用光速实现深度学习,跟GPU说再见

如果说GPU养大了深度学习,那么如今深度学习的胃口早已经超越了GPU。

当然,GPU在不断发展,也出现了TPU、IPU、MLU来满足这头巨兽。

深度学习对算力的需求没有止境,但受制于能耗和物理极限,基于硅基的电子元件虽然现在还能支撑,但远处那堵几乎不可逾越的高墙已然显现。

怎么办?

光速深度学习!

今天,Science发表了加州大学洛杉矶分校(UCLA)研究人员的最新研究:All-optical machine learning using diffractive deep neural networks,他们使用 3D 打印打造了一套 “全光学” 人工神经网络,可以分析大量数据并以光速识别目标。

论文地址:http://science.sciencemag.org/content/361/6406/1004

这项技术名为衍射深度神经网络( diffractive deep neural network,D²NN),它使用来自物体的光散射来识别目标。该技术基于深度学习的被动衍射层设计。

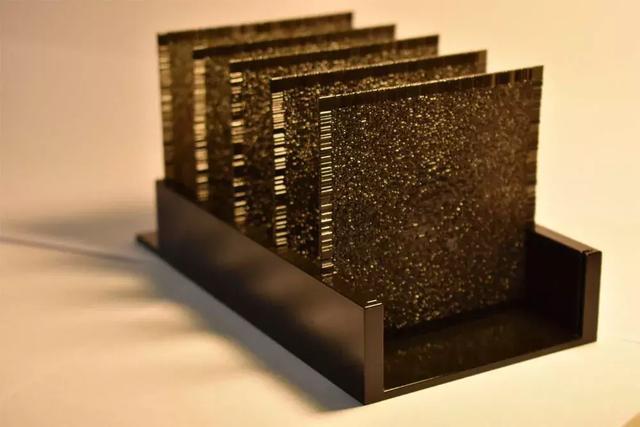

研究团队先用计算机进行模拟,然后用 3D 打印机打造出 8 平方厘米的聚合物层。每个晶圆表面都是不平整的,目的是为了衍射来自目标的光线。

衍射深度神经网络由一系列聚合物层组成,每层大约 8 平方厘米。利用网络区域内的光的衍射传播路径来识别目标。

研究人员使用 THz 级频率的光穿透 3D 打印的网络层。每一层网络由数万个像素组成,光可以通过这些像素传播。

研究人员为每类的目标分配像素,来自目标的光被衍射到已分配给该目标类型的像素上。这样,衍射深度神经网络就能够识别目标,其耗时与计算机 “看到” 目标所花费的时间相仿。

的。

D²NN: 光速实时学习,成本不到 50 美元

而随着来自不同目标的光通过 D²NN, 研究人员利用深度学习训练神经网络,以学习每个目标产生的衍射光图案。

“我们使用逐层制造的无源元件,并通过光的衍射将这些层相互连接起来,打造一个独特的全光平台,可以以光速执行机器学习任务。” 该研究团队负责人,加州大学洛杉矶分校教授 Aydogan Ozcan 表示。

“这就像一个由玻璃和镜子构成的复杂迷宫。光进入衍射网络,并在迷宫周围反射,直到其离开该区域为止。系统能够根据某目标产生的大部分光最终离开迷宫的路径,确定究竟是哪个目标。”Ozcan 说。

在实验中,研究人员将图像放在 THz 级频率的光源前。 D²NN 通过光学衍射对图像进行观察。研究人员发现,该设备可以准确识别手写的数字和衣服,这两类对象都是人工智能研究中的常用目标。

图为 D²NN 设备识别文本

在训练中,研究人员还该将设备作为成像的镜头,就像一般的相机镜头一样。

由于 D²NN 的组成可以由 3D 打印制造,成本低廉,可以构建规模更大、数量更多的层,制造出包含数亿个人工神经元(像素)的设备。规模较大的设备可以同时识别更多的目标,执行更复杂的数据分析。

D²NN 的组件成本低廉。研究人员表示,他们使用的 D²NN 设备成本不到 50 美元。

虽然这项研究使用的是 Thz 级光谱中的光,但 Ozcan 表示,也可以打造使用可见光、红外线或其他频率光谱的神经网络。他表示,除 3D 打印外,D²NN 也可以使用光刻或其他印刷技术打造。

全光学衍射深度神经网络(D²NN)的 3D 打印衍射板

D²NN的设计和性能:MNIST分类准确率达到91.75%

在论文中,研究人员介绍了D²NN框架的技术细节、实验和测试性能。

在D²NN全光学深度学习框架中,神经网络物理上由多层衍射表面(diffractive surfaces)形成,这些衍射表面协同工作以光学地执行网络可以统计学习的任意功能。虽然这个物理网络的推理和预测机制都是光学的,但其学习部分是通过计算机完成的。

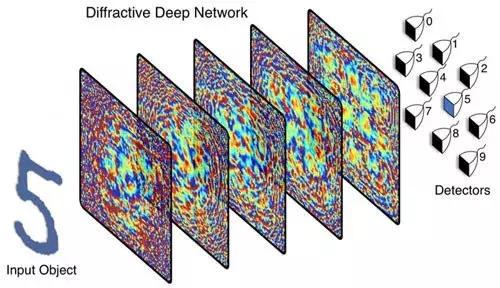

研究者将这个框架称为衍射深度神经网络( diffractive deep neural network,D²NN),并通过模拟和实验证明了其推理能力。D²NN可以通过使用几个透射和/或反射层进行物理创建,其中给定层上的每个点都传输或反射进来的光波,每个点代表一个人工神经元,通过光学衍射连接到后续的层。如图1A所示。

图1:衍射深度神经网络D²NN

D²NN 中的人工神经元通过由通过振幅和相位调制的次级波连接到下一层的其他神经元。图1D是标准深度神经网络的一个类比,可以将每个点或神经元的传输或反射系数视为一个“bias”项,这是一个可学习的网络参数,在训练过程中使用误差反向传播方法进行迭代调整。

经过这一数值训练阶段, D²NN的设计就固定了,并且确定了各层神经元的传输或反射系数。这种 D²NN设计可以以光速执行所训练的特定任务,仅使用光学衍射和无源光学器件(passive optical components)或无需功率的层,从而创建一种高效、快速的方式来实现机器学习任务。

一般来说,每个神经元的相位和振幅可以是可学习的参数,在每一层提供复值调制(complex-valued modulation),这改善了衍射网络的推理性能。 对于phase-only调制的同调传输网络,每层可以近似为一个薄的光学元件(图1)。通过深度学习,在输入层馈送训练数据并通过光学衍射计算网络输出,每一层的神经元的phase value迭代调整(训练)来执行一个特定的函数。

在计算目标输出误差的基础上,通过误差反向传播算法优化网络结构及其神经元相位值。误差反向传播算法基于传统深度学习中的随机梯度下降法。

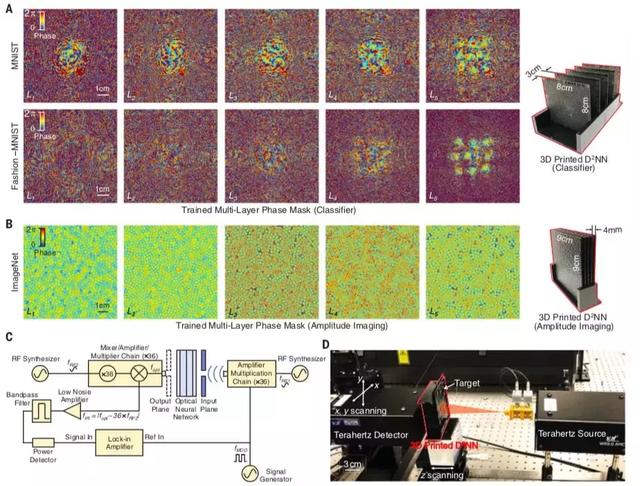

D²NN性能:MNIST手写数字数据集

为了演示 D²NN框架的性能,我们首先将其训练成一个数字分类器,对从0到9的手写数字进行自动分类(图1B)。

为了完成这项任务,我们设计了一个五层的D²NN,其中包含来自MNIST手写数字数据集的5.5万张图像(5000张验证图像)。我们将输入数字编码到D²NN输入域的幅值中,训练衍射网络将输入数字映射到10个检测器区域,每个检测器区域对应一个数字。分类标准是寻找具有最大光信号的检测器,相当于网络训练过程中的损失函数。

在训练之后,使用来自MNIST测试数据集的10000个图像(未用作训练或验证图像集)对D²NN数字分类器进行数值测试,并且实现了91.75%的分类精度(图3C)。

根据这些数值结果,我们将这个5层的D²NN 设计3D打印出来(下图),每一层的面积为8cm×8cm,然后在衍射网络的输出平面定义10个检测器区域(图1B)。

图2:3D打印的D²NN的实验测试

然后,我们使用0.4 THz的连续波光照来测试网络的推理性能(图2,C和D)。

每一层神经元的相位值用3D打印神经元的相对厚度进行物理编码。对这个5层的D²NN设计的数值测试显示,在 ~10000幅测试图像中,分类准确率达到91.75%(图3C)。

图3: D²NN手写数字识别器的性能

D²NN性能:Fashion-MNIST数据集

接下来,为了测试D²NN框架的分类性能,研究者使用了一个更复杂的图像数据集——Fashion-MNIST数据集,其中包含10个类别的时尚产品。

D²NN对Fashion-MNIST数据集的分类结果如下图所示。具有N = 5个衍射层的phase-only和complex valued的D²NN的分类精度分别达到81.13%和86.33%。

通过将衍射层的数量增加到N = 10,并将神经元的总数增加到40万,D²NN的分类精度提高到86.60%。对比而言,在已有研究中,基于卷积神经网络的标准深度学习,使用~890万可学习参数和~250万个神经元,Fashion-MNIST分类准确度的最高性能为96.7%。

光学神经网络的应用

光学电路深度学习是一项重大突破,而且其现实应用已经逐渐

根据光学领域权威期刊Optica的报道,美国斯坦福大学的研究人员已经证明,可以直接在光学芯片上训练人工神经网络。这一重大突破表明,光学电路可以实现基于电子的人工神经网络的关键功能,从而可以以更便宜、更快速和更节能的方式执行语音识别、图像识别等复杂任务。

不仅如此,斯坦福的另一组研究人员还研究出一套小型AI成像系统,采用双层光学-电子混合计算技术,成像精度和速度均达到电子计算处理器水平。具体说,研究人员在电子计算之前加上一层光学计算,这种AI成像系统在低光照条件下具备更强的成像能力,每个立体像素上的光电子密度最高可达几十个,同时节约了大量本该用于计算的时间和成本。

具体到这项研究,UCLA的研究团队表示,他们的 D²NN 设备可用于全光学图像分析、特征检测和对象分类任务,还可以实现使用 D²NN 执行任务的新相机设计和光学组件。

例如,使用该技术的无人驾驶汽车可以立即对停车标志作出反应,一旦收到从标志衍射来的光,D²NN 就可以读取标志信息。该技术还可用于对大量目标的分类任务,比如在数百万细胞样本中寻找疾病的迹象。

“这项研究为基于人工智能的被动设备提供了新机会,可以对数据和图像进行实时分析,并对目标进行分类。”Ozcan 说。“这种光学人工神经网络设备直观地模拟了大脑处理信息的方式,具备很高的可扩展性,可以应用到新的相机设计和独特的光学组件设计中,也可用于医疗技术、机器人、安全等领域。”

论文:

http://science.sciencemag.org/content/361/6406/1004

参考链接:

https://www.photonics.com/Articles/All-Optical_Diffractive_Deep_Neural_Network_Is/a63751

https://newatlas.com/diffractive-deep-neural-network-uses-light-to-learn/55718/

Science重磅!用光速实现深度学习,跟GPU说再见http://t.jinritoutiao.js.cn/dSWhvM/