画个草图生成2K高清视频,这份效果惊艳研究值得你跑一跑

选自GitHub,作者:Ting-Chun Wang 等,机器之心编译,参与:刘晓坤、王淑婷。

在图像到图像合成的研究领域热火朝天的当下,英伟达又放大招,联合 MIT CSAIL 开发出了直接视频到视频的转换系统。该系统不仅能用语义分割掩码视频合成真实街景视频,分辨率达到 2K;能用草图视频合成真实人物视频;还能用姿态图合成真人舞蹈视频。更令人惊艳的是,在语义分割掩码输入下,换个掩码颜色该系统就能直接将街景中的树变成建筑!目前该项目已开源。

- 项目展示:https://tcwang0509.github.io/vid2vid/

- 项目地址:https://github.com/NVIDIA/vid2vid

1 引言

模拟和再现动态视觉世界对于打造智能体来说必不可少。除了纯粹的科学兴趣,学习合成连续的视觉体验在计算机视觉、机器人学和计算机图形学领域都有广泛的应用。例如对于 model-based 的强化学习,逼近动态视觉的视频合成模型能以较少的真实体验数据训练智能体。使用学习的视频合成模型,人们可以生成逼真的视频,而无需明确指定场景几何形状、材料、光传输以及它们的变换,这在使用标准图形渲染技术时会遇到很多麻烦,但却是必要的。

视频合成的形式有很多种,包括未来视频预测和无条件视频合成。在本文中,作者研究了一种新的形式:视频到视频的合成。从核心来说,其目标是学习一种映射函数,它可以将输入视频转换成输出视频。就目前已知的研究工作来看,尽管图像到图像合成研究进行得热火朝天,但视频合成的通用解决方案还没有被探索过。作者表示,本论文提出的方法是受到之前专用视频合成方法启发。

作者将视频到视频的合成问题称之为分布匹配问题,其目标是训练一个模型,使得在给定输入视频后构建一个条件分布以近似合成类似于输入视频的真实视频。为此,他们利用了生成对抗学习框架完成这一建模过程。

给定成对的输入和输出视频,作者学习把输入视频映射到输出域。通过精心设计的生成器和判别器网络以及新的学习目标函数,该方法可以学习合成高分辨率、时间连贯的照片级视频。此外,作者还将该方法扩展到多模态视频合成。在相同的输入条件下,该模型可以制作不同外观的视频。

作者对在几个数据集上进行了广泛的实验验证,任务是将一些列分割掩码转换成照片级的视频。定量和定性结果都表明,该方法合成的镜头看起来比强基线更逼真。他们还进一步证明,该方法可以生成长达 30 秒的真实感 2K 分辨率视频。它还允许用户对视频生成结果进行灵活的高级控制。例如,用户可以轻易地用街景视频中的树替换建筑物。此外,作者还将该方法扩展到了未来预测,结果表明其方法优于现有系统。作者所用代码、模型和其它结果都可以在其网站上找到。

图 1:Cityscapes 结果。其中左上为输入图像、右上为 pix2pixHD 生成的图像、左下为 COVST 生成的图像、右下为本论文提出方法生成的图像。

论文:Video-to-Video Synthesis

论文地址:https://tcwang0509.github.io/vid2vid/paper_vid2vid.pdf

摘要:我们研究了视频到视频的合成问题,目标是学习从输入源视频(例如,一系列的语义分割掩码)到输出照片级视频的映射函数,输出视频精确地描绘了源视频的内容。与之对应的图像问题,即图像到图像合成问题是目前流行的研究课题,而视频到视频的合成问题则在文献中很少出现。在没有理解时间动力学的情况下,直接把已有的图像合成方法应用到输入视频通常会导致视觉效果低、时间不连贯的视频。在本文中,我们提出了一种新型的生成对抗网络框架下的视频到视频合成方法。通过精心设计生成器和判别器架构,结合空间-时间对抗目标函数,我们在多种输入视频格式下生成了高分辨率、时间连贯的照片级视频,其中多种形式的输入包括分割掩码、草图和姿态图。在多个基准上的实验结果表明,相对于强基线,我们的方法更具优越性。特别地,我们的模型可以合成长达 30 秒的 2K 分辨率街景视频,与当前最佳的视频合成方法相比具备显著的优势。最后,我们把该方法应用到未来视频预测中,结果超越了多个当前的最佳系统。

4 实验

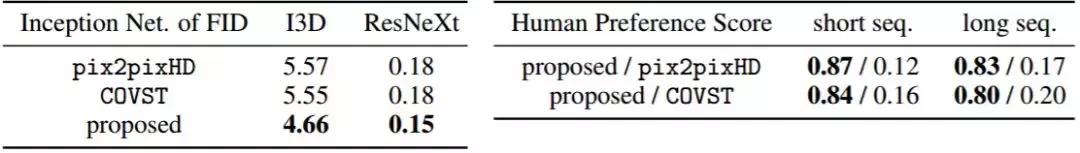

表 1:在 Cityscapes 街景数据集上视频到视频合成方法的对比结果。

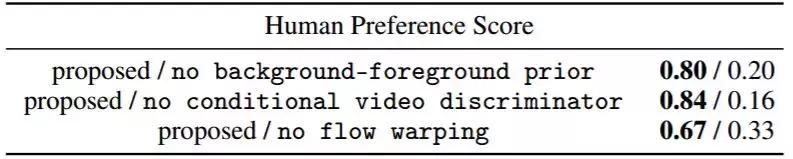

表 2:控制变量研究。作者对比了提出的方法和 3 个变体的性能。分别是初始 vs 无背景-前景先验;初始 vs 无条件视频判别器;初始 vs 无流扭曲。

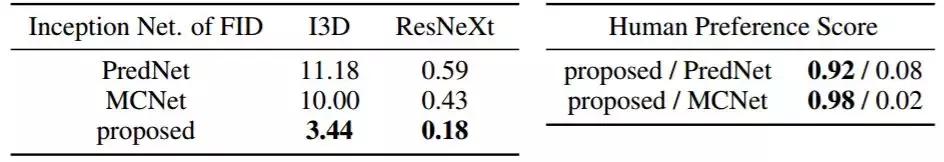

表 3:在 Cityscapes 数据集上未来视频预测方法的对比结果。

图 2:Apolloscape 的结果。左图:pix2pixHD。中间:COVST。右图:作者提出的方法。输入语义分割掩码视频在左下角展示。

画个草图生成2K高清视频,这份效果惊艳研究值得你跑一跑http://t.jinritoutiao.js.cn/dM9jt9/